Вступление

Если у вас есть желание закрыть некоторые материалы своего сайта от поисковых и других ботов, используется три метода:

Во-первых, создаётся файл robots.txt в котором специальными записями закрываются/открываются части контента. Важно, что файл robots.txt запрещает роботам сканировать URL сайта;

Во-вторых, на HTML(XHTML) страницах или в HTTP заголовке прописывается мета–тег robots с атрибутами noindex (не показывает страницу в поиске) и/или nofollow (не разрешает боту обходить ссылки страницы). Синтаксис мета тега robots:

<meta name="robots" content="noindex, nofollow" />Важно, что мета–тег robots работает, если есть доступ ботов к сканированию страниц, где мета тег прописан. То есть они не закрыты файлом

robots.txt.

В-третьих, можно создавать закрытые разделы сайта.

При составлении файла robots.txt полезно проверять правильность его составления. Для этого предлагаю посмотреть следующие инструменты проверки файла robots.txt.

Инструменты проверки файла robots.txt

Напомню, что в классическом варианте в файле robots.txt создаются отдельные директивы для агента пользователя Yandex (user-agent: yandex) и других поисковых ботов сети, включая Googleboot (user-agent: *).

Инструмент проверки №1

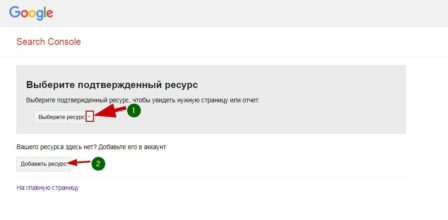

Google в возможностях Searh Console оставил инструмент проверки файла robots.txt. Вот ссылка на него: https://www.google.com/webmasters/tools/robots-testing-tool

Вот скрин:

Для использования инструмента вам нужно зарегистрироваться инструментах веб–мастеров Google и добавить в них свой ресурс (сайт). Если вы всё это сделали, просто выберете сайт для проверки.

После выбора сайту откроется инструмент проверки файла robots.txt. Внизу читаем ошибки и предупреждения. Если их нет, то смотрим ещё ниже и видим сам инструмент проверки.

В форме проверки указываете проверяемый URL, выбираете бота Google (по умолчанию Googleboot) и жмёте кнопку «Проверить».

Результат проверки будет показан на этой же станице в виде зелёной надписи «Доступен» или красной надписи «Не доступен». Всё просто и понятно.

Инструмент проверки №2

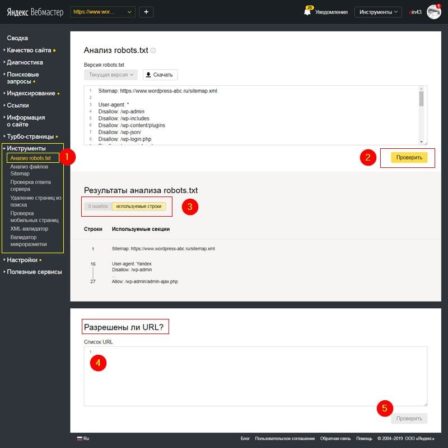

По логике составления файла robots.txt о которой я напомнил выше, такой же инструмент проверки должен быть в веб–инструментах Яндекс для ботов Yandex. Смотрим. Действительно, в вашем аккаунте Яндекс Веб–мастер выбираете заранее добавленный ресурс (свой сайт).

В меню «Инструменты» есть вкладка «Анализ robots.txt», где проверяется весь файл robots на ошибки и проверяются отдельные URL сайта на закрытие в файле robots.

Независимые инструменты проверки файла robots.txt

Встаёт логичный вопрос, можно ли проверить файл robots.txt и его работу независимо от инструментов веб мастеров? Наверняка можно.

Во-первых, чтобы просмотреть доступность своего файла robots впишите в браузер его адрес. Он должен открыться и нормально читаться. Проверку можно сделать в нескольких браузерах.

Адрес файла должен быть:

http(s)://ваш_домен/robots.txt

Во-вторых, используйте для проверки файла следующие инструменты:

Websiteplanet.com

https://www.websiteplanet.com/ru/webtools/robots-txt/

Дотошный инструмент, выявляет ошибки и предупреждения, которые не показывают сами боты.

Seositecheckup.com

https://seositecheckup.com/tools/robotstxt-test

Англоязычный инструмент проверки файла robots.txt на ошибки. Регистрация не требуется. Хотя навязывается сервисом. Результаты в виде диаграммы.

Стоит отметить, что с июня сего года (2019) правила для составления файла robots.txt стали стандартом и распространяются на всех ботов. Так что выявленные ошибки для бота Google, будут ошибками и для бота Yandex.

Technicalseo.com

https://technicalseo.com/tools/robots-txt/

Протестируйте и подтвердите ваш robots.txt с помощью этого инструмента тестирования. Проверьте, заблокирован ли URL-адрес, какой оператор его блокирует и для какого агента пользователя. Вы также можете проверить, запрещены ли ресурсы для страницы (CSS, JavaScript, IMG).

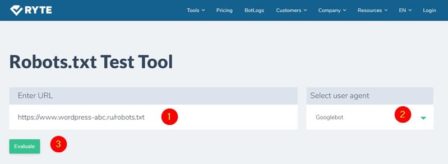

en.ryte.com

https://en.ryte.com/free-tools/robots-txt/

Просто вписывает адрес своего файла и делаете проверку. Показывает предупреждения по синтаксису файла.

Вывод про инструменты проверки файла robots.txt

По-моему, лучшие инструменты проверки файла robots.txt находятся в инструментах веб–мастеров. Они ближе к источнику и более чувствительны к изменениям правил.

Кстати, есть проверка файла robots.txt в инструментах веб–мастеров Mail поисковика (https://webmaster.mail.ru/) и была у поисковика Bing.

Еще статьи

- 7 простых шагов базовой оптимизации WordPress сайта

- Почему не оптимизированная статья попадает в ТОП выдачи по обоим поисковикам

- Секреты создания успешного сайта

- Как ускорить загрузку JS скриптов, CSS и HTML сайта WordPress: плагин Autoptimize

- Законная накрутка подписчиков в ютуб

- Зачем вам нужен прокси сервер

- Как я пытался сократить время открытия сайта: почему я отключил плагин Jetpack